Ihr Vibe-Codierungsprojekt ist voller Sicherheitslücken!

Die Entwicklung von Software mit KI ist von Science-Fiction zur alltäglichen Realität geworden. Ihr KI-codiertes Projekt funktioniert möglicherweise einwandfrei … bis Hacker die Schwachstellen finden. In diesem Beitrag beschreiben wir den Weg vom KI-generierten Code voller Erkenntnisse und Schwachstellen zu einem vertrauenswürdigen Produkt. Dazu führen wir durch ein Experiment, das wir durchgeführt haben, um die KI-agentischen Analyse- und automatischen Korrektur-Workflows von Scribe an einem realen Projekt zu testen, das mit der Vibe-Codierungsplattform Bolt.new erstellt wurde.

Generieren des Projekts

Die Herausforderung war einfach:

Erstellen Sie eine Webanwendung, die Hardware-GPIO-Leitungen in Echtzeit überwacht und ihren Status auf einer dynamisch aktualisierten Webseite anzeigt.

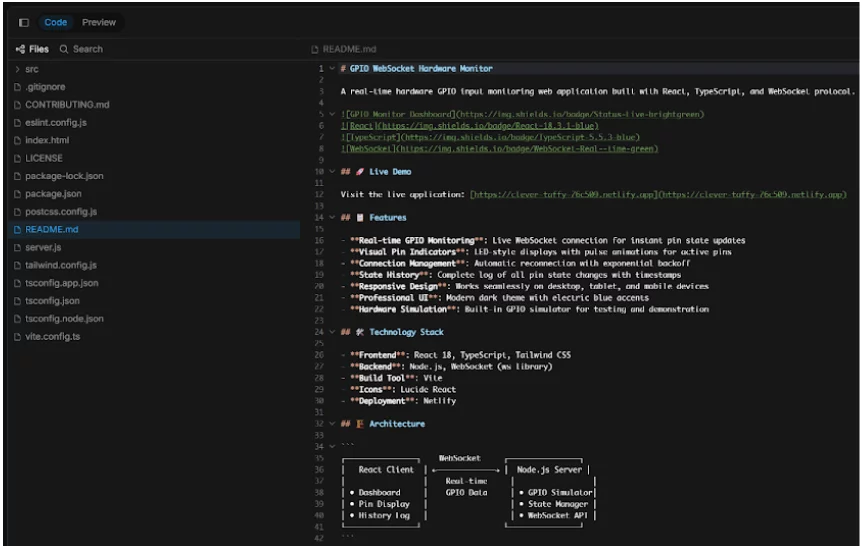

Mit einer einzigen Eingabeaufforderung generierte Bolt.new das gesamte Projekt – ein Node.js-Projekt mit einem WebSocket-Server, einem React.js-Frontend und sogar einer README.md-Datei für GitHub.

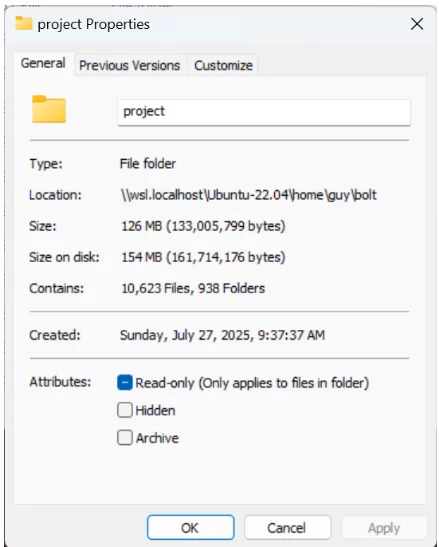

Der Generierungsprozess dauerte nur drei Minuten und wir konnten den Code in eine lokale Linux-Umgebung (Ubuntu 22.04 auf WSL) herunterladen, installieren und ausführen.

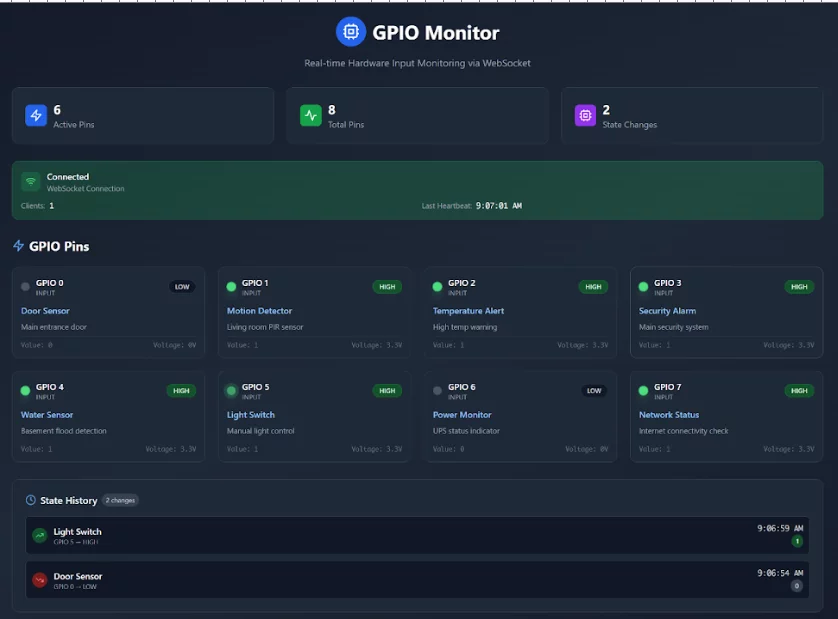

Es hat sofort funktioniert, was uns überrascht hat. Hier ist der Screenshot der laufenden App:

Erste Eindrücke

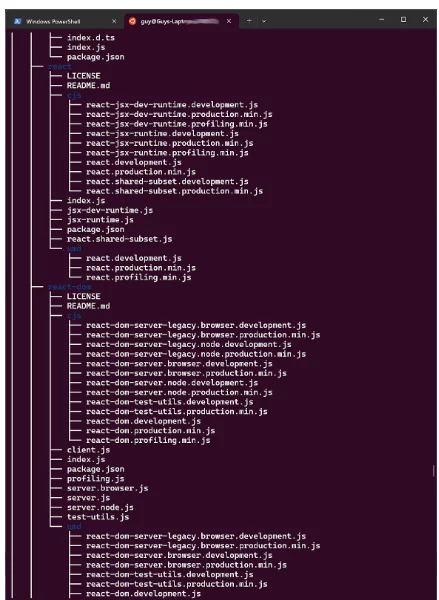

Nach der Bereitstellung haben wir uns eingehend mit der Projektstruktur befasst. Die App bestand aus 20 Quellcodedateien und 15 Konfigurationsdateien. Die komplette Installation inklusive Abhängigkeiten umfasste über 10,000 Dateien. Das warf eine wichtige Frage auf: Wie sicher und zuverlässig ist dieser KI-generierte Code?

Phase 1: Traditionelle Instrumentierung

Unser erster Schritt bestand darin, die klassische Instrumentierung von Scribe auszuführen und Sicherheitsnachweise aus dem Build-Prozess zu sammeln. Dies ergab:

– Detaillierte SBOMs (Software-Stücklisten)

– Schwachstellenberichte (direkte und transitive Abhängigkeiten)

– SAST-Ergebnisse (statische Analyse)

– Geheime Scan-Ergebnisse

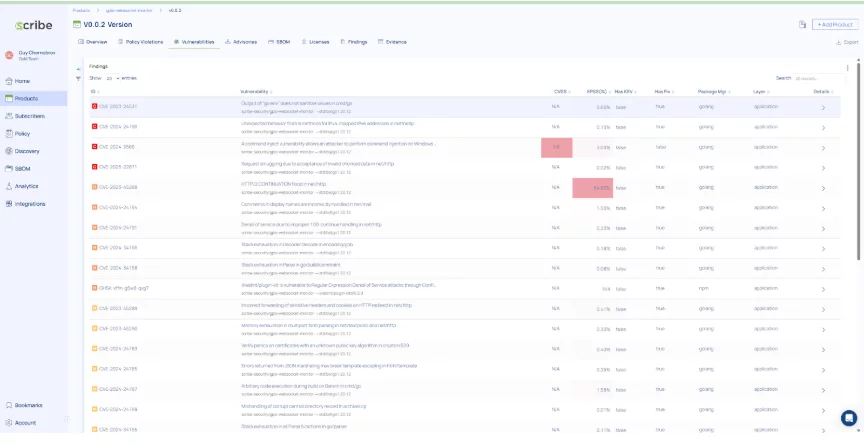

Schwachstellenbericht

- 4 kritische Sicherheitslücken

- 6 schwerwiegende Sicherheitslücken

SAST-Ergebnisse

- 3 schwerwiegende Befunde

- 12 Befunde mittleren Schweregrades

Phase 2: Automatische Fehlerbehebung mit Scribe AI

Als nächstes haben wir das Projekt auf GitHub hochgeladen und verwendet Remus, der KI-basierte Agenten-Workflow zur automatischen Korrektur von Scribe. RemusIn der Tat ein Netzwerk von vier AI-Agentenist für den autonomen und kollaborativen Betrieb konzipiert. Jeder Agent verfügt über spezielle Fähigkeiten, die einen verteilten Ansatz zur Lösung komplexer Probleme ermöglichen. Diese Architektur ermöglicht dem Tool die Bewältigung eines breiten Aufgabenspektrums, von der Datenanalyse und Mustererkennung bis hin zur Entscheidungsfindung und prädiktiven Modellierung.

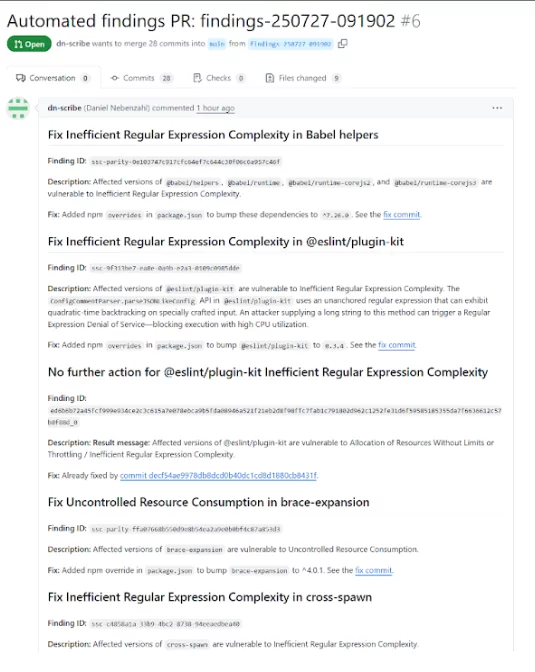

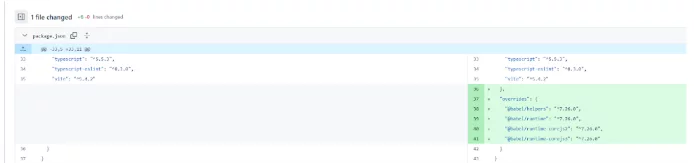

Laufen Remus führte zu einem Pull Request mit gezielten Korrekturen für die zuvor identifizierten Schwachstellen und SAST-Probleme.

Hier ist ein Beispiel für einen Commit, der automatisch vorgeschlagen wird von Remus So beheben Sie eine Sicherheitslücke:

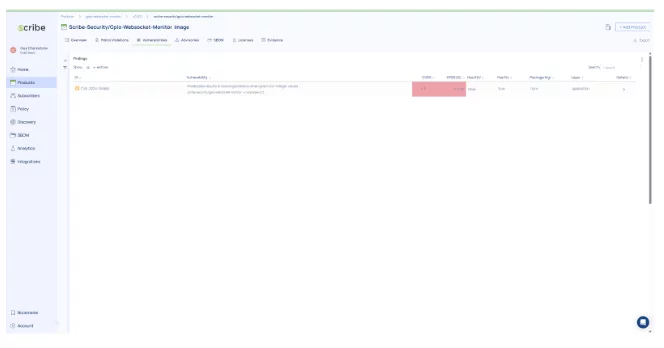

Nach dem Zusammenführen des PR haben wir das Projekt neu erstellt, überprüft, ob es wie zuvor funktioniert, und das Projekt erneut auf Probleme überprüft.

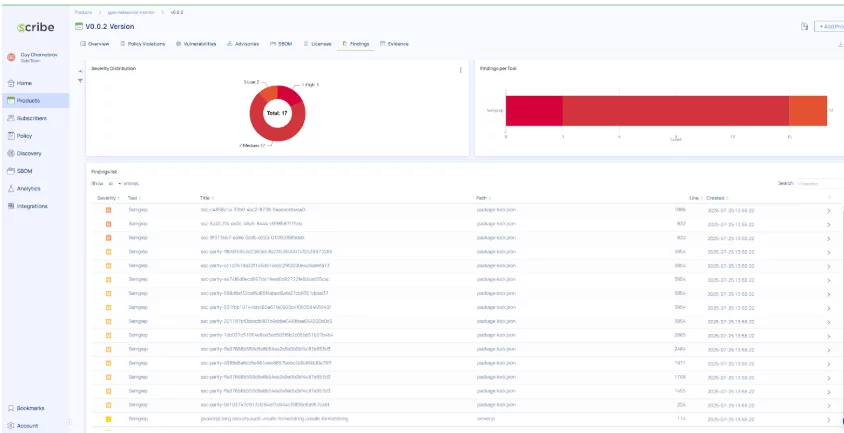

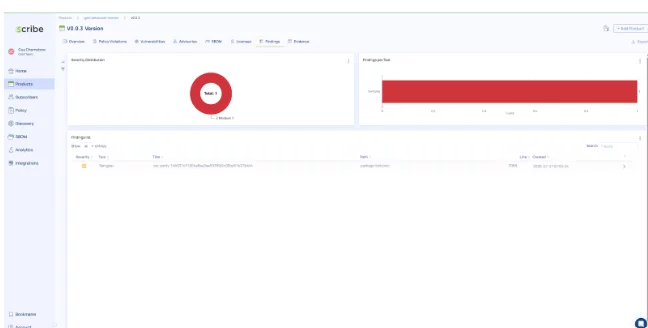

Ergebnisse nach Remus Remediation

Die Verwandlung war dramatisch!

- Schwachstellen-Scan: Es blieb nur noch 1 Problem mit mittlerem Schweregrad übrig

- SAST-Ergebnisse: alle behoben, außer einem Element mit mittlerem Schweregrad

Der KI-basierte, agentenbasierte Behebungsworkflow von Scribe löste kritische und schwerwiegende Probleme effektiv und ließ nur kleinere Probleme für manuelle Eingriffe übrig, ohne die Funktionalität des Produkts zu beeinträchtigen.

Key Take Away

Dieses Experiment zeigte, dass:

- KI-generierter Code mag zunächst voll funktionsfähig erscheinen, doch seine Out-of-the-Box-Funktionalität birgt erhebliche Sicherheitsrisiken und Vertrauensbedenken. Projekte, die solchen Code verwenden, sind einem hohen Risiko durch Bedrohungsakteure ausgesetzt.

- Sicherheitsinstrumente in der Pipeline sind unerlässlich. Das GitHub-Plugin von Scribe hat mehrere schwerwiegende Schwachstellen im generierten Projekt aufgedeckt.

- Der auf KI basierende automatische Abhilfe-Agenten-Workflow von Scribe ist leistungsstark: Er reduzierte das Risikoprofil des Projekts durch automatisierte Korrekturen drastisch, während das Projekt voll funktionsfähig blieb.

Abschließende Gedanken

Die Kombination aus KI-generierten Projekten und KI-gesteuerter Sanierung lässt eine Zukunft erwarten, in der Software schneller als je zuvor erstellt und gesichert wird. Während menschliche Kontrolle weiterhin entscheidend ist, können Tools wie ScribeHub mit seinen KI-agentischen AppSec-Workflows beweisen, dass die automatisierte Codereparatur nicht nur möglich, sondern auch praktisch ist.

Diese Inhalte werden Ihnen von Scribe Security zur Verfügung gestellt, einem führenden Anbieter von End-to-End-Sicherheitslösungen für die Software-Lieferkette, der modernste Sicherheit für Code-Artefakte sowie Code-Entwicklungs- und Bereitstellungsprozesse in der gesamten Software-Lieferkette bietet. Weitere Informationen.